الورقة البحثية بعنوان “تصميم وتطوير أداة رسم خرائط للمكفوفين وضعاف البصر“

“Design & Development Of Mapping Tool For The

Blind Or Partially Sighted”

تأليف وتنفيذ: إيمان أسكور، نعيم عجلوني 2022،

تم النشر في مجلة

The Manchester Journal of Artificial Intelligence & Applied Science(MJAIAS)

(https://mjaias.co.uk/mj-en/article/view/37 ).

ترجمة هدية خليل، وحقوق الترجمة محفوظة.

تدقيق نور عمار

آخر المقال يحتوي على الورقة البحثية باللغة الإنجليزي

الملخص

يواجه الأشخاص الذين يعانون من الإعاقات البصرية العديد من التحديات خلال قيامهم بالمهام والأنشطة اليومية البسيطة دون الحاجة إلى مساعدة من الاخرين او الكلاب المدربة بهذا الخصوص. تهدف هذه الدراسة لتطوير حل مثالي لهذه المشكلة. الحل سيعتمد على تقنيات الذكاء الاصطناعي، على سبيل المثال الرؤية الحاسوبية، وتحويل النصوص الى صوت بشكل ذكي، اكتشاف الكائنات والعقبات، ونقل المعلومات بشكل شفهي. سيعرض الحل المقترح تقنيات مساعدة مثل النظارات والعصى الذكية، لمساعدة ذوي الإعاقة البصرية للتنقل الداخلي والخارجي على حد سواء. الحل أيضاً يقدم ميزة قراءة الكتب. في هذه الدراسة النظام سيقدم النظام القدرة على اكتشاف الكائنات والعقبات في الداخل والخارج، والتعرف على النصوص وتحويلها إلى صوت في الوقت الفعلي، مما سيوفر المعلومات للمستخدمين لمساعدتهم في حل مشاكل التنقل واكتشاف المشكلات. سيتم اجراء اختبار الاستخدام الشامل للتحقق من أداء النظام وقدرته على تحقيق المهام التي صُمِم لأجلها بفاعلية، بما في ذلك الاختبار في ظل ظروف بيئية عديدة، كالاختبار تحت الضوء النهاري العادي والساطع، وفي الظلام الدامس. القدرة على تحويل النصوص لصوت تم اختباره حيث نجح النظام في الترجمة النصية للفيديو والنصوص من الصور بنفس الكفاءة. تشير النتائج إلى أن النظام يعمل بشكل جيد في جميع الحالات.

ABSTRACT– People who have visual impairment face many problems doing their simple daily activities without needing the help of other people or specially trained dogs. This study intends to design and develop an optimal solution. The solution will be based on artificial intelligence technologies such as computer vision, intelligent text to voice conversion, detecting objects and/or obstacles, and conveying the information verbally. This will offer modern assistance techniques such as smart glasses and canes, helping the needy navigate indoor and outdoor. The solution will also provide a book reading capability. In this study, a system offering indoor and outdoor object detection, obstacle detection and real-time text recognition and conversion to audio will provide users with information to help them overcome navigation and detection problems. A comprehensive test will be carried out to check the ability of the system to achieve its designated task effectively, environmental test conditions, including tool performance under normal daylight, high or bright light, and total darkness. The text to voice ability was tested, in which case the system detected video subtitles and text from images equally well. The results indicate that the system performs equally well in all cases.

الكلمات المفتاحية: ضعف البصر، والنظارات الذكية، واكتشاف الأشياء، والرؤية الحاسوبية، والذكاء الاصطناعي، والتحويل من التعرف الضوئي على الحروف إلى الصوت.

1. المقدمة

في العامين 2020 و2021، تم اكتشاف مرض جديد في 31 ديسمبر 2019 ويُدعى فايروس كوفيد-19. وقد انتشر في العالم بأسره، وأعلنته منظمة الصحة العالمية وباءً رسمياً في 11 مارس 2020، مما أدى لانتشار القلق بين الدول. حينها رغب الجميع في معرفة المزيد من المعلومات حول الفايروس المذكور، أعراضه، معدل الوفيات الناجمة عنه، مما شكل ضغطاً هائلاً على موظفي مراكز الرعاية الصحية ومكاتب الاستقبال.

لتوفير المعلومات للعدد الأكبر من الأشخاص حول العالم، يمكن طرح حل بواسطة تقنيات الذكاء الاصطناعي. روبوت الدردشة هو برنامج آلي يتفاعل مع البشر، وهو برنامج حاسوبي ذكي يحاكي بشكل كبير المحادثات البشرية [1 ،2 ،3]. تُظهر تقييمات واجهة المستخدم لروبوت الدردشة الخاص بكوفيد-19 [4] أن النهج الأفضل هو روبوت الدردشة التفاعلي الذي يمكنه الاجابة على أسئلة المستخدم بطريقة المحادثات النصية مع ترك حرية التعبير للمستخدم في صياغة السؤال وهو ما تعتمد عليه تقنيات الذكاء الاصطناعي كما تم التوضيح في مقدمة الورقة.

هنالك هياكل بيانات مختلفة لتصنيف المحادثات النصية، كنموذج تضمين الكلمات (word2vec) [5]، ونموذج تضمين الكلمات (GloVe) [6] اللذان يحتويان على قواميس الكلمات، ومثل نهج مجموعة الكلمات (BoW) [7] ، ونهج (BoW TF-IDF) [8] اللذان يقومان بتحويل البيانات النصية إلى بيانات عددية وعرضها بصورة نواتج رسومية.

تحتوي الشبكات العصبية الذكية (ANN) طبقة واحدة غير مرئية تستخدم الدالة سيجموند والأوزان التشابكية (Synoptic weights). نتيجة النموذج كانت تكفي للقبول نظراً لتعقيد البيانات وعدم تشابهها مع النماذج في المصادر [8، 10، 11] حيث استخدم الباحثون التصنيف الذي يعتمد على فئات متعددة. في النموذج الخاص بهذه الدراسة، هناك فئة واحدة فقط يمكن التنبؤ بها وهي السؤال الصحيح نفسه، وهو يقوم بتنبؤ سؤال المستخدم الى السؤال الصحيح الأكثر تشابهاً مع السؤال المطروح من قِبَل المستخدم في مجموعة البيانات، ثم يتم طباعة الاجابة عبر واجهة المستخدم الرسومية (GUI) لروبوت الدردشة. تمت مقارنة النموذج مع ثلاث نماذج (BERT)، (TF-IDF)، (وGloVe) في القسم الخامس في الورقة البحثية.

2. الدراسات السابقة

أُجريَت العديد من الدراسات والبحوث لتحسين حياة الأشخاص ذوي الإعاقة البصري. حيث قام المؤلف في (Barontini F et al. , 2020) بمقابلة العديد من الأشخاص ذوي الإعاقة البصرية لنمذجة فكرة حول المزايا والخصائص التي يجب أن تمتلكها اداة التنقل المثالية، الهدف الأساسي لهذا النظام يستند على معلومات لمسية ومحاكاة لمسية. في هذه الحالة، يرتدي المستخدم جهازًا يدويًا مزودًا بمحرك لمساعدة الشخص المكفوف أثناء الحركة، على سبيل المثال، إذا انتقل إلى اليمين، سيقوم الجهاز بقرصه على ذراعه اليمنى، في (Mauro Avila et al،2015) المؤلف طور نظامًا للتنقل يتيح للشخص المكفوف تحديد العناوين أو الغرف. كما يهدف المؤلف في (Tanveer et al.، 2015) إلى مساعدتهم في التنقل وتتبع مواقعهم في حالة ضياعهم باستخدام نظام تحديد المواقع العالمي GPS، يقترح النظام لغتين للمساعدة الصوتية (البنغالية والإنجليزية). في (Real et al.، 2019) قدم المؤلف تقنيات لمساعدة المطورين المستقبليين المهتمين بالعمل ومساعدة الأشخاص ذوي الإعاقة البصرية، ناقش المؤلف مزايا وعيوب كل طريقة مقترحة. لذلك، اختار مؤلف هذه الورقة العلمية: تحديد الموقع الداخلي، وتحميل الحسابات، والاستشعار الموزع، وما إلى ذلك. وقد اتبع المؤلف أساليب مختلفة تم اقتراحها في الماضي لتوضيح نقاط القوة والضعف لكل طريقة تم عرضها. تم استخراج بعض الميزات الأساسية المهمة للمساعد المثالي في المشي من (M. M. Islam et al.، 2019) بعد مراجعة تفصيلية. ويشمل ذلك التكلفة المنخفضة، والتصميم الخفيف والبسيط مع تغطية موثوقة للداخل والخارج. تمت دراسة أخرى (D. Dakopoulos et al.، 2010) بناءً على تعليقات من عدة مجموعات من المستخدمين ذوي الإعاقة البصرية لاستخراج 14 سمة تشغيلية لوصف مساعد المشي المثالي.

فيما يتعلق بكشف الكائنات/الكائنات، حاول العديد من الباحثين مساعدة الأشخاص في تجنب العقبات (Ali et al.، 2017)؛ بما في ذلك استخدام الطائرات بدون طيار في هذا المجال كخيار (C. Yi et al.، 2013). اقترح المؤلف في (Rahmat Tullah et al.، 2020) مساعدًا للمشي للمكفوفين يستخدم أجهزة استشعار فوق صوتية لقياس المسافات بين الكائنات المكتشفة والشخص المصاب وينتج صوتًا من جرسه إذا كانت المسافة بينهما أقل من 100 سم كتحذير. يوفر هذا المساعد أيضًا إمكانية اكتشاف وجود بركة ماء أمام المستخدم.

تم استخدام مستشعرات الهواتف الذكية في دراسة (M. Ehatisham-ul-Haq et al., 2017) للكشف عن الأنشطة التي يقوم بها المستخدم، مثل المشي، الوقوف، الجلوس، الجري، وغيرها. وكانت عملية التعرف في الوقت الفعلي تعتمد على التعرف على النشاط البدني للمستخدم. العمل المقدم في (Shifa Shaikh et al., 2020) هو حل يعتمد على تعلم الآلة، حيث يهدف بشكل رئيسي إلى استخراج الميزات باستخدام إطار عمل YOLO المتخصص في كشف الأجسام. كما يوفر النظام أيضًا خيار تحويل النصوص إلى كلام لوصف البيئة المحيطة بالمستخدم. مثال آخر جيد هو (Shankar Sivan et al., 2016)، جهاز مساعد يتضمن عدة وحدات مثل كشف الكائنات، التعرف على النصوص، واكتشاف الأبواب، ويحتوي أيضًا على نظام أمني للمساعدة في اكتشاف المتسللين.

استنادًا إلى إمكانيات خدمات الرؤية الحاسوبية، تم تطوير نموذج أولي في (Hasventhran Baskaran et al., 2019) لإنشاء سرد يصف العالم الحقيقي عن طريق صياغة جمل كاملة مثل “مجموعة من الأشخاص تقرأ” و”طائر جالس على شجرة”، ثم يتم تحويل هذه الجمل إلى كلام في الوقت الحقيقي. المثال الأخير يستخدم Raspberry Pi كمعالج للتحكم في كشف وتتبع الوجوه (P. Velrajkumar et al., 2020) باستخدام معالجة الصور. وقد أجريت عدة دراسات بحثية في مجال كشف الأجسام (Bai, S et al., 2018 – S. Pehlivan et al. 2019)، حيث قدمت كل منها حلولًا مختلفة لكشف العقبات (R. Radhika et al., 2016 – Sami UR Rahman et al., 2018).

ومع ذلك، فإن التحدي الرئيسي للأشخاص المكفوفين أو ذوي البصر الضعيف في التعرف على النصوص وتحويل النصوص المعروفة إلى صوت، بما في ذلك قراءة الكتب، لا يزال موجودا، البحث الذي أُجري في (Roy Shilkrot et al., 2015) يقدم جهاز قراءة محمول يوفر نظامًا فعالًا بدقة مقبولة باستخدام تكنولوجيا الرؤية الحاسوبية لمسح النصوص المطبوعة. النظام المقدم في (P. Sabin Prasanna et al., 2018) يتيح للأشخاص المكفوفين قراءة الكتب في الوقت الحقيقي عن طريق تحويل النص المكتشف إلى صوت. الأشخاص المكفوفون أو الذين يعانون من مشاكل بصرية خطيرة يواجهون تحديات يومية عديدة، من ضمنها التنقل داخل البيئة المغلقة أو العالم الخارجي المفتوح والقراءة.

في هذه الأيام هناك العديد من الأدوات المتاحة في السوق لمساعدة ذوي الإعاقة البصرية، ولكنها لا تحل المشاكل كافة، فهمي اما تكن غير مناسبة، أو تحل مشكلة واحدة ما يعني أن المستخدم سيحتاج للعديد من الأدوات لحل جميع المشاكل. الهدف الأساسي من هذا العمل هو تقديم جهاز واحد للمكفوفين يقدم حلولا للعديد من المشكلات الكبرى التي يواجهها الاشخاص ذوي الإعاقة، وهو نظام مساعد في الوقت الفعلي وبدقة عالية. وهو يقدم خيارات للتنقل سواء في مساحة داخلية محصورة أو مساحة خارجية مفتوحة، بما في ذلك التنقل ضمن المناطق المزدحمة، وقراءة النصوص، وترجمة النصوص إلى ثلاث لغات (الإنجليزية، الفرنسية، والتركية).

3. المشكلة

أ. النظام المقترح

النظام المقترح سيستخدم فرعين من أفرع الذكاء الاصطناعي، التعلم العميق والرؤية الحاسوبية، لتحقيق اكتشاف الكائنات وتعريفها، اضافة الى خيارات اخرى ستشرح في هذا القسم، تم تقسيم المشروع لقسمين أساسيين:

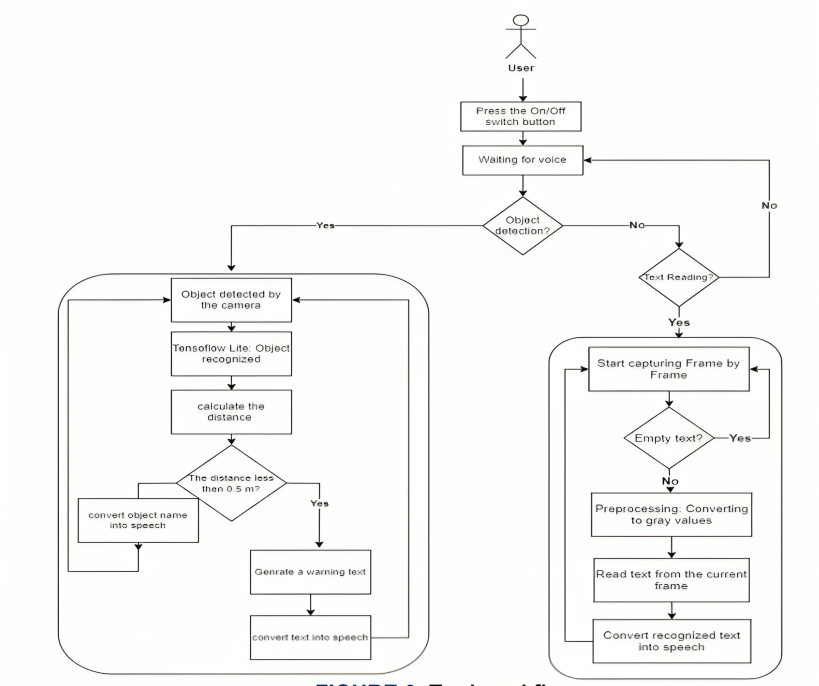

1) اكتشاف الكائنات

سيتم تزويد المستخدم بمعلومات حيوية حول الكائنات في بيئته، بما في ذلك كشف الأجسام والعقبات، وسيمكن المستخدم من تجنبها في الوقت الحقيقي من خلال تقديم تفاصيل الكائنات المكتشفة بشكل صوتي.

2) قراءة النصوص

الأداة ستكتشف أي محتوى نصي من الصور والفيديوهات، ثم سيتم تحويلها لنص، ثم صوت. العملية ستبدأ باكتشاف ثم تحديد النص ومن ثم تحوله لكلام. النص المكتشف مترجم لثلاث لغات (التركية، الانجليزية، والفرنسية). هذا يعني أن الاداة ستسمح للمستخدم بقراءة أو الاستماع وفهم الفيديوهات التي تحتوي على نصوص مترجمة.

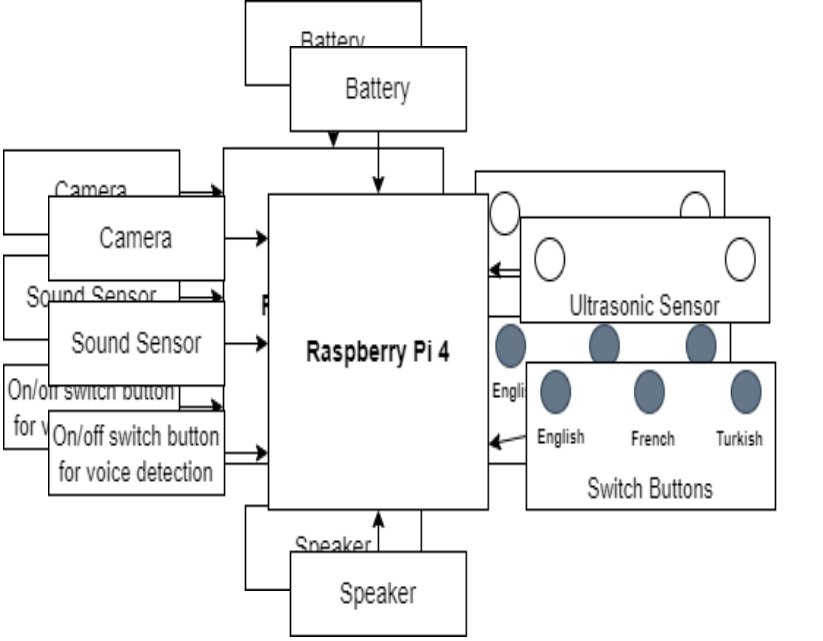

الرسم 3 يعرض الهيكلية للنظام المقدم، وهو يحتوي على الوحدات التالية:

– قائمة بأصوات الذكاء الاصطناعي.

– اكتشاف الكائنات.

– اكتشاف النصوص.

– تحويل النصوص لكلام.

– حساب المسافات وكشف العقبات.

4. التنفيذ

النظام المقدم يحتوي على مكونات برمجية وفيزيائية/مادية، سيتم وصف التفاصيل في هذا القسم.

أ. المكونات الهيكلية

المكونات المادية والهيكلية تحتوي على أجهزة ومستشعرات متعددة لتحقيق الهدف من هذا العمل، وتحتوي على:

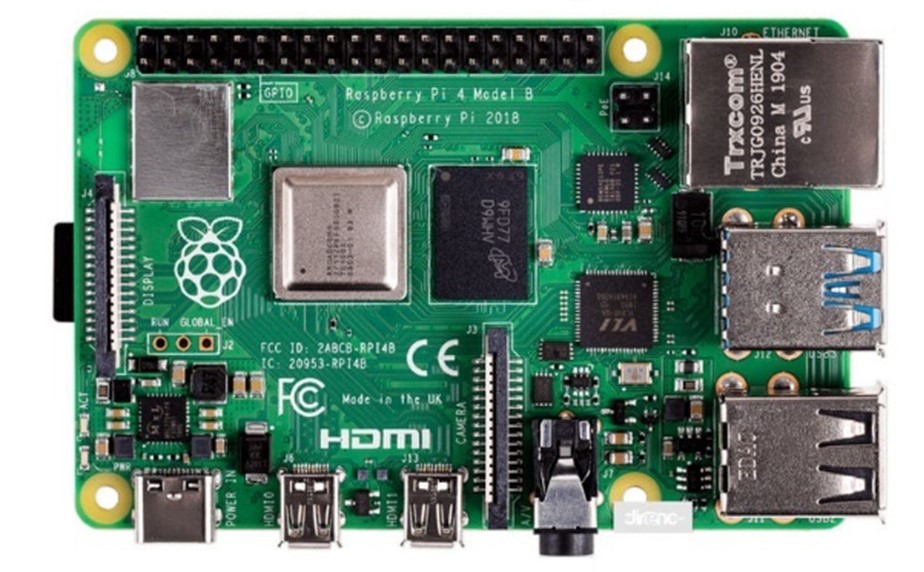

1- Raspberry Pi 4: تعد Raspberry Pi 4 حاسوباً صغيراً، يمكن استخدامه كحاسوب عندما يوَصَل بشاشة ولوحة مفاتيح. هي تمتاز بحجمها الصغير وسعرها المقبول مما جعل Raspberry Pi مثالية لأداء المهام الحيوية، بما في ذلك معالجة الفيديوهات والصور، ومعالجة اللغات الطبيعية، وهي أيضًا تدعم لغات برمجة عديدة كجافا، وبايثون، وسي بلس في هذا العمل وحدة تحكم Raspberry Pi ستمثل وحدة المعالجة الرئيسية للنظام.

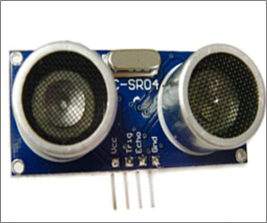

2- مستشعر المسافة بالموجات فوق الصوتية Ultrasonic Distance sensor: في هذا العمل تم استخدام العديد من المستشعرات المختلفة للمساعدة في تحقيق وتنفيذ مهمة النظام المقترح، بما في ذلك مستشعر المسافة بالموجات فوق الصوتية. مستشعر المسافة فوق الصوتية لقياس المسافة بين الكائنات/ الأجسام (العقبات) باستخدام موجات الصوت. هذه الموجات تنتقل بتردد معين، المستشعر في هذه الحالة ينتظر لاكتشاف موجة عكسية. يتم حساب المسافة بين مستشعر المسافة والعائق من خلال حساب الفترة الزمنية بين الارسال والاستقبال. مستشعر قياس المسافة بالموجات فوق الصوتية قد لا يستطيع توقع المسافة بدقة إذا كان هناك عدد من الكائنات في نفس الوقت فبض هذه الأجسام تعكس الموجة بشكل جيد كباقي الأجسام. ومع ذلك، بسبب التكلفة والميزانية المالية، يتم استخدام المستشعر للتحقق من قدرة الأدوات على اكتشاف والتعامل مع الأجسام والعقبات.

3- كاميرا Raspberry Pi: تحتوي الكاميرا التالية على إمكانية تصوير فيديو بدقة عالية، كما تلتقط الصور التي يتم إرسالها إلى RPi. بعد اختبار الأداة تحت ظروف تشغيل متنوعة، يتم ضبط تردد التقاط الصور لتحقيق الأداء الأمثل.

4- مستشعر الصوت: مستشعر الصوت هو مستشعر لاقط الصوت من البيئة المحيطة ويولِد إشارات رقمية، يتم تزويد المستشعر بترمومتر متغير يسمح له بالكشف عن تصفيق اليدين، بما في ذلك أصوات الأبواق، الأصوات المفاجئة والصاخبة أو الضوضاء البيئية. يتم تحقيق الإعداد الأمثل من خلال اختبار تشغيل الأداة في ظل ظروف قاسية. السبب وراء استخدام مستشعر الصوت هو تزويد الأدوات بالقدرة اللازمة لتحديد التعرف على الصوت المحيط ومستوى الصوت، والذي سيتم استخدامه لتقدير مصدر الأصوات وكذلك استخدام الموجات الصوتية لتحديد هوية المصدر.

ب. المكونات البرمجية

عدد من المكونات البرمجية تم استخدامها لتطوير تطبيق عملي باستخدام الأداة المقترحة. تشمل أدوات البرمجيات المستخدمة لغة البرمجة Python، وأداة الويب التفاعلية المعروفة بدفتر الحسابات، وحل TensorFlow الخفيف للأجهزة المحمولة والمضمنة، ومكتبة Open Source Computer Vision.

- OpenCV: مكتبة مفتوحة المصدر للرؤية الحاسوبية (Open Source Computer Vision Library) هي مكتبة متعددة المنصات يمكن أن تساعد في تطوير تطبيقات الرؤية الحاسوبية في الوقت الفعلي. وهو تركز في الأساس على معالجة الصور، والتقاط الفيديو، وتحليله، بما في ذلك خاصية اكتشاف الوجوه، واكتشاف الكائنات.

تم تطويره لتوفير بنية تحتية مشتركة لتطبيقات الرؤية الحاسوبية وتسريع إدراك الآلات في المنتجات التجارية. باعتباره منتجًا مرخصًا بموجب BSD، فإن OpenCV يسهل على الشركات استخدام وتعديل الكود (URL-7). في هذا المشروع، يُستخدم OpenCV لاكتشاف الأجسام والنصوص والتقاط الصور ومن ثم رسم النتائج عليها.

- التعرف على الكلام: هو احدى تقنيات تعلم الآلة حيث يتم مرير الصوت عبر بعض طبقات التعلم العميق ويسجل الخصائص التي يمكن أن تستخدم لتدريب النظام للتصنيف والتوقع. يمكن أيضًا استخدامها لتعريف وتحويل الصوت لنص، وهو ما يعرف ب “Text To Speech” في هذه الحالة تعلم الآلة يتعرف على الكلمات المنطوقة بواسطة الشخص ثم يحولها الى نص مقروء (URL-8). تقوم أنظمة التعرف على الكلام بمعالجة وتفسير الكلمات المنطوقة عبر الخوارزميات ومن ثم تحويلها إلى نص. تبدأ العملية بتحليل ملف الصوت، ثم يتم تقسيمه إلى مقاطع وتحويله إلى صيغة قابلة للقراءة بواسطة الحاسوب. أخيرًا، تقوم خوارزمية مناسبة بمطابقته مع التمثيل النصي الأنسب.

- التعرف البصري على الأحرف (OCR): تستخدم هذه التقنية لاكتشاف النص في البث المباشر، الجزء المسؤول عن التعرف هو تقنية ال OCR وهي تقنية تُستخدم لتمييز الحروف المطبوعة أو المكتوبة بخط اليد داخل الصور الرقمية للمستندات المادية، مثل المستندات الممسوحة ضوئيًا. تتضمن عملية OCR الأساسية فحص نص المستند وترجمة الحروف إلى تمثيل رقمي يمكن استخدامه في معالجة البيانات. يُشار إلى OCR أحيانًا أيضًا باسم التعرف على النص.

5. النظام المقترح

5. النظام المقترح

في هذا القسم ستتم مناقشة البرمجيات والمعدات ذات الصلة بالأداة المقترحة. تم تصميم وتطوير مكونات البرمجيات المستخدمة في هذا العمل باستخدام وحدة معالجة Raspberry Pi. تم تصميم وتعديل المعدات ذات الصلة بكل مكون برمجي باستخدام المكونات الإلكترونية الضرورية، بما في ذلك المقاومات المتغيرة، لتحقيق إشارات أجهزة مثالية. يوضح الشكل 8 مخطط الكتل للنظام المقترح. بعد أن أصبحت جميع المكونات عملية وتم اختبارها بشكل منفصل، تم ربطها معًا واحدة تلو الأخرى لتكوين النظام الكامل. شملت عملية التكامل عدة أخطاء تطلبت، في بعض الحالات، تعديلات على الأجهزة والبرمجيات ذات الصلة. بعد توصيل جميع المكونات، تم إجراء اختبار كامل للوظائف تحت جميع ظروف العمل الممكنة للتحقق من قدرة الأداة على تحقيق هدفها. من الشكل 8، يمكن ملاحظة أن النظام يشمل Raspberry Pi، كاميرا Raspberry Pi، مستشعر الأشعة فوق الصوتية، مكبر صوت، مستشعر لاقط صوت، ثلاث وحدات تبديل تشغيل/إيقاف، وأزرار تبديل. يحتوي النظام على أربع وحدات رئيسية. يتم استعراض هذه الوحدات في هذا القسم.

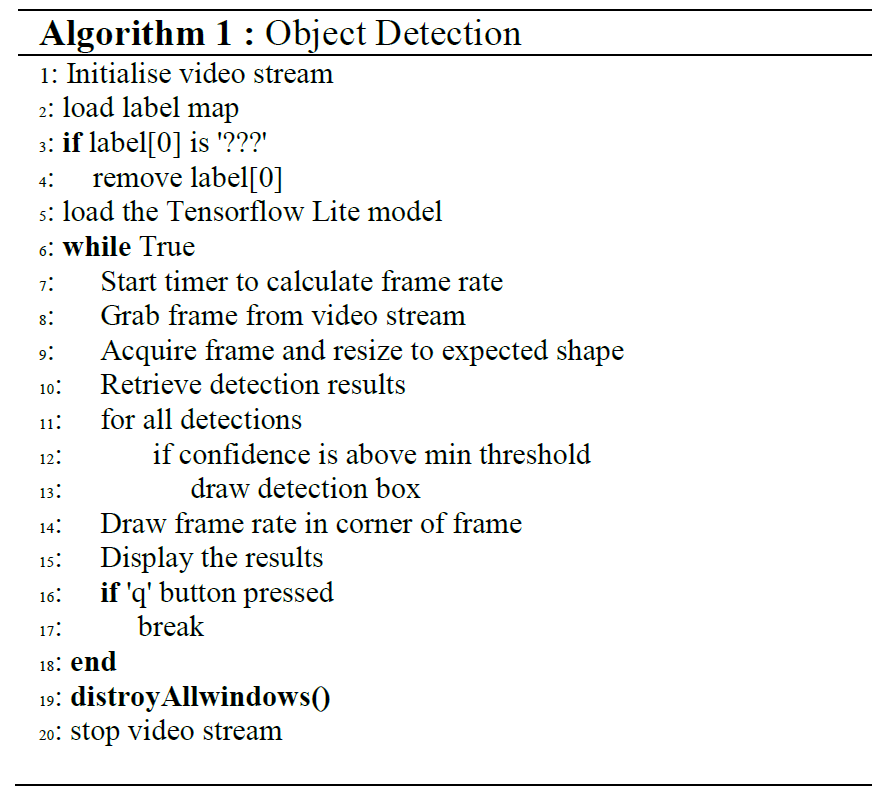

أ. كشف الكائنات

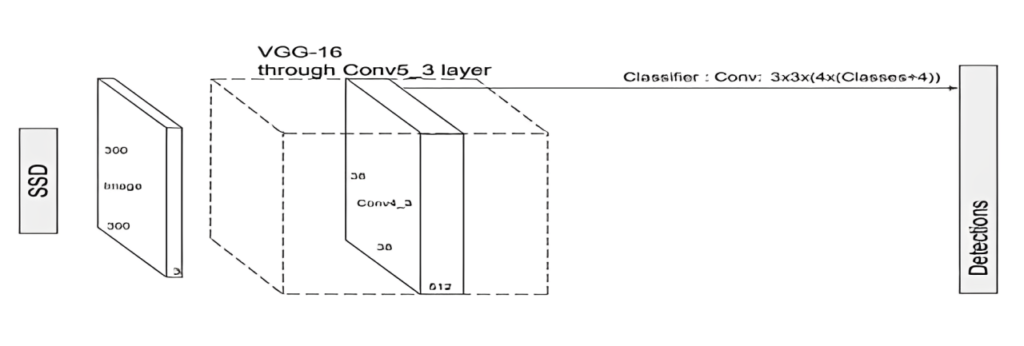

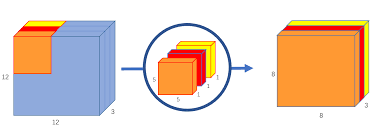

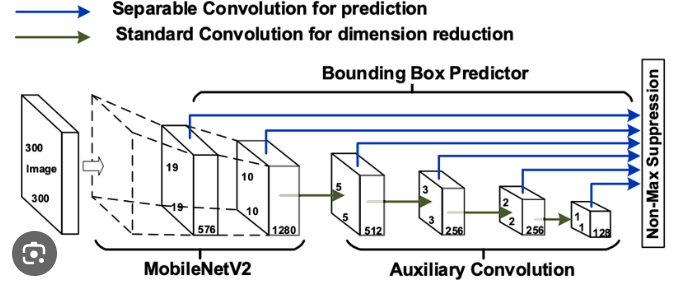

تم تصميم كاشف الأجسام متعدد الصناديق (SSD) للكشف عن الأجسام في الوقت الفعلي، حيث يستغرق الأمر لقطة واحدة فقط لاكتشاف عدة أجسام موجودة في الصورة باستخدام صناديق متعددة. تُعد بنية (Mark Sandler, et al) إطارًا لشبكة عصبونية التفافية (CNN) تتكون من عنصرين: الأول هو مستخلص الميزات والذي يُعرف أيضًا بالشبكة الأساسية، ويليه مجموعة من الطبقات الالتفافية المساعدة التي تتيح استخراج الميزات على مقاييس متعددة، وتقليل حجم الإدخال لكل طبقة لاحقة، والثاني هو مُن prognosticator للحدود والذي يتكون من مجموعة من الفلاتر الالتفافية الصغيرة المستخدمة للتنبؤ بدرجات الفئات وتحويلات الصناديق لمجموعة ثابتة من الصناديق الافتراضية. يقوم SSD بإلغاء اقتراحات الصناديق مثل تلك المستخدمة في RCNN، ويشمل فلتر تلافيفي يتناقص تدريجياً لتنبؤ فئات الأجسام وتحويلات مواقع الصناديق. يوفر SSD دقة وسرعة عالية باستخدام دقة صورة أقل للأسباب المذكورة.

VGG-16 يعرض قاعدة الشبكة التي تسمح باستخراج خرائط المميزات ثم يكتشف ال SSD الكائنات باستخدام طبقات التلافيف التي تقيم الصناديق ذات نسب الأبعاد المختلفة في كل موقع ضمن عدة خرائط ميزات بمقاييس مختلفة.

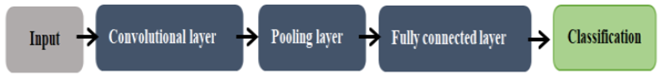

تعد الشبكة العصبونية الالتفافية (CNN) شبكة عصبية عميقة يمكنها التعرف على الأنماط البصرية من خلال الصورة المدخلة مع الحد الأدنى من المعالجة المسبقة مقارنة بخوارزميات تصنيف الصور الأخرى. إنها تنتج نتائج تعرف دقيقة للغاية ويمكن إعادة تدريبها لمهام التعرف الجديدة دون الحاجة لبناء على الشبكات الموجودة مسبقًا. الوحدة المهمة داخل طبقات CNN هي العصبون. تتصل هذه العصبونات معًا بحيث يصبح إخراج العصبونات في طبقة ما هو مدخل العصبونات في الطبقة التالية.

كما في الرسم 10 نموذج ال CNN يحتوي على 3 أنواع من الطبقات:

– طبقة التلافيف (The convolutional layer): هي العنصر الأساسي في بناء CNN. تقوم هذه الطبقة بتنفيذ عملية ضرب نقطي بين مصفوفتين، حيث تكون إحداهما مجموعة من المعلمات القابلة للتعلم تُعرف أيضًا بالنواة، والمصفوفة الأخرى هي الجزء المحدود من مجال الاستقبال.

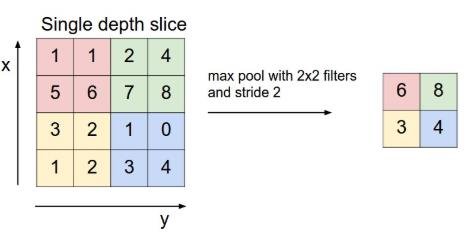

– طبقة الاختزال (Pooling layer): تستبدل إخراج الشبكة في مواقع محددة من خلال اشتقاق إحصائية ملخصة للمخرجات المجاورة. يساعد ذلك في تقليل الحجم المكاني للتمثيل، مما يقلل من كمية الحساب والوزن المطلوبة. تتم عملية الاختزال على كل شريحة من التمثيل بشكل فردي. ستستخدم الشبكة عدة طبقات اختزال، ولكن الأكثر شيوعًا هو الاختزال للقيمة الأعلى (Max Pooling) (الشكل 11)، الذي يحدد المخرجات الأعلى من مربعات الجوار.

– الطبقة المتصلة بالكامل (Fully Connected Layer): هي شبكة عصبية متعددة الطبقات وتقليدية تستخدم دالة تفعيل في طبقة الإخراج للمساعدة في رسم التمثيل بين المدخلات والإخراج. تحتوي العصبونات في هذه الطبقة على اتصال كامل مع جميع العصبونات في الطبقة السابقة واللاحقة.

هناك العديد من أنواع الشبكات العصبونية الالتفافية. إحدى فئات الشبكات العصبونية الالتفافية هي الشبكات العصبونية الالتفافية العميقة (Depth-Wise Convolutional Neural Networks). العمق هو نوع من التلافيف حيث يتم تطبيق فلتر تلافيف واحد لكل قناة إدخال. تقوم التلافيف ذات العمق بتقسيم الإدخال والفلتر إلى قنوات، وتلافيف كل إدخال بالفلتر المعني، وتجميع مخرجات التلافيف معًا (الشكل 12). مقارنة بشبكة عصبية التفافية تقليدية، فإن الأداء العميق باستخدام مضاعفات أقل يعني نشر نماذج الشبكات العصبية الالتفافية بشكل أسرع دون فقدان صحة تعرف كبيرة.

في هذا العمل، تم استخدام ال SSDLite وهو نسخة صديقة للأجهزة المحمولة من SSD، حيث تستبدل التلافيف ذات العمق بالتلافيف العادية في مُتنبئ الصناديق (Bounding Box Predictor). استنادًا إلى إطار عمل SSDLite، تستخدم SSDLite-MobileNetV2 (الشكل 13) MobileNetV2 كشبكة أساسية.

مجموعة بيانات MSCOCO (الكائنات الشائعة في السياق) هي مجموعة بيانات كبيرة لتصنيف الكائنات والتقسيم والتعليق تم نشرها بواسطة Microsoft. تفسر مكتبات الشبكات العصبية المتقدمة تنسيق هذه المجموعة تلقائيًا. لذا، النموذج المستخدم ككاشف للأجسام في هذا النظام هو SSDLite-MobileNetV2.

(Mark Sandler et al.) تم تدريب النموذج على مجموعة بيانات MSCOCO (URL-11) ثم تم تحويلها للعمل على TensorFlow Lite (URL-12).

بعض خصائص مجموعة البيانات COCO:

– 80 فئة كائنات، ُعرف باسم “فئات COCO”، التي تشمل “الكائنات” التي يمكن تصنيفها بسهولة (مثل الكرسي، التلفاز، الهاتف المحمول، السيارات، الأكواب…إلخ).

– 5 تسميات لكل صورة.

– أكثر من 200000 صورة من اجمالي 330000 صورة تم تصنيفها

– 250000 شخص مع 17 نقطة مفتاحية مختلفة.

الكود البرمجي التجريبي لخوارزمية كشف الكائنات، كما يلي:

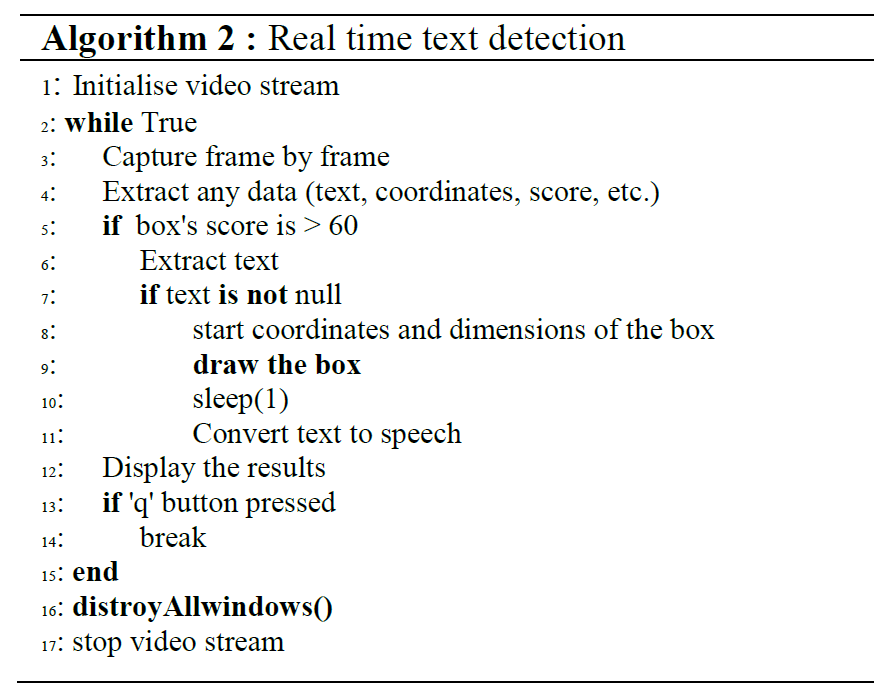

ب. التعرف على النصوص

تستخدم تقنية التعرف الضوئي على الأحرف (OCR) لتمييز النصوص المطبوعة أو المكتوبة بخط اليد داخل الصور الرقمية للمستندات المادية في الوقت الفعلي.

الخطوات المتضمنة في ال (OCR) تمثل كما يلي:

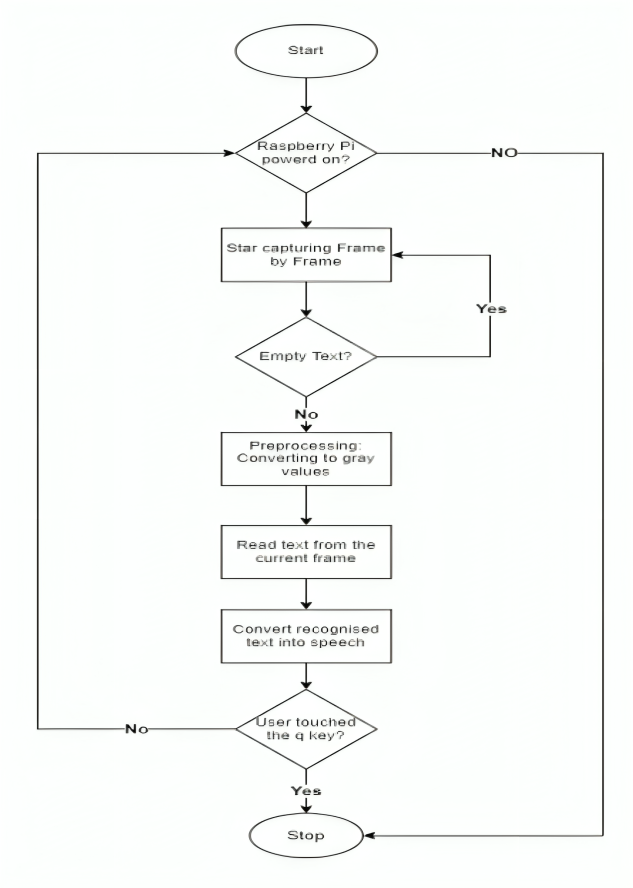

في البداية، يجب توصيل كاميرا Raspberry Pi والتعرف عليها لالتقاط الإطارات واحدة تلو الأخرى، بمجرد اكتشاف الإطار الحالي، يتم تنفيذ وظيفة المعالجة المسبقة لتحويله إلى قيم رمادية وتمكين اكتشاف البيانات، حتى تلك التي تكون ساطعة جدًا. بعد ذلك، إذا لم يظهر الإطار المكتشف نصًا فارغًا، يتم استخراج البيانات ورسم صندوق يحددها. سيستمر السيناريو في التنفيذ بينما ينتظر المستخدم للضغط على مفتاح “Q” والخروج من العملية.

الكود البرمجي التجريبي للتعرف على النصوص في الوقت الفعلي كما يلي:

ج. تحويل النص لكلام

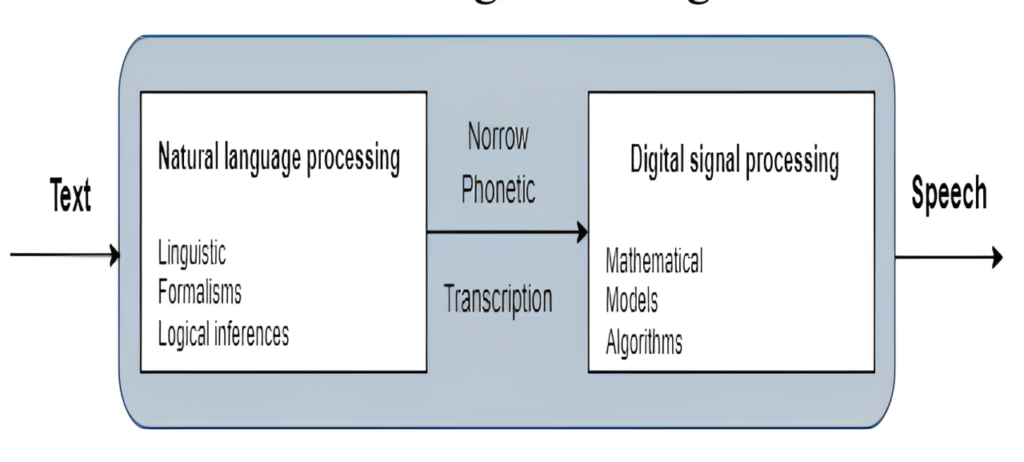

للحصول على ردود فعل صوتية، سواء لجزء كشف الكائنات، أو التعرف على النصوص، أو لتوليد رسائل تحذيرية للعقبات، تم استخدام محولات النص إلى كلام (TTS). يعني تحويل النص إلى كلام تحويل النص المكتوب إلى كلام طبيعي قابل للفهم. في هذه الدراسة، تم استخدام مكتبات مبنية مسبقًا. بنية محول النص إلى كلام موضحة في الشكل 15.

معالجة اللغات الطبيعية (Elizabeth D, 2011) تشمل قراءة وفهم اللغات المحكية أو المكتوبة من خلال وسيط الحاسوب، مثل الترجمة التلقائية من لغة لأخرى، الاجابة التلقائية على الأسئلة، وغيرها. تستخدم NLP الآلات لتشغيل خوارزميات التعلم العميق لفهم تواصل النصوص من المستخدمين والرد بذكاء عليهم بالاعتماد على تكوينات التدفق. تقوم معالجة الاشارات الرقمية (DSP) تأخذ اشارات العالم الحقيقي مثل الصوت، والبيانات الصوتية، والفيديو، ودرجة الحرارة، والضغط، أو الموقع، والتي تم تحويلها إلى بيانات رقمية، ثم تقوم بمعالجتها رياضيًا.

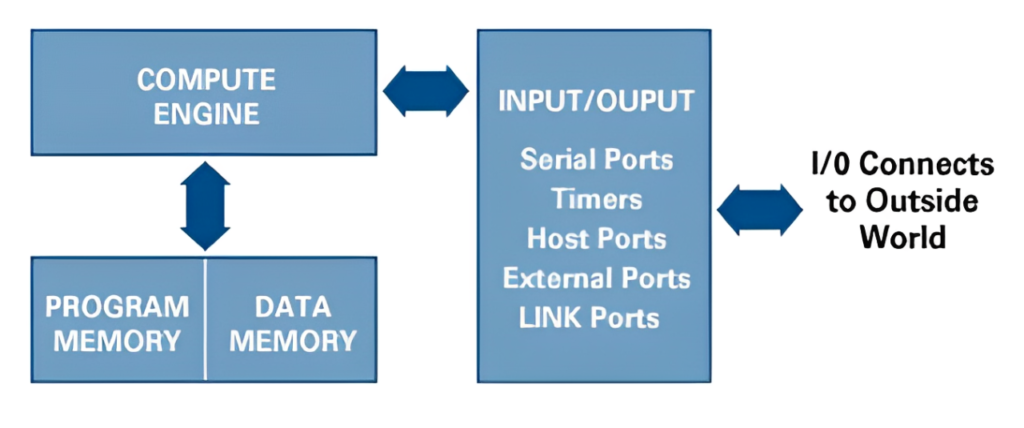

عملية معالجة الاشارات الرقمية تحتوي هذه المكونات الرئيسية:

– ذاكرة البرنامج: تخزن البرامج التي ستستخدمها DSP لمعالجة البيانات.

– ذاكرة البيانات: تخزن المعلومات التي سيتم معالجتها.

– محرك الحسابات: ينفذ العمليات الرياضية، ويقوم بالوصول إلى البرنامج من ذاكرة البرنامج وإلى البيانات من ذاكرة البيانات.

– الإدخال/الإخراج: يؤدي مجموعة من الوظائف للاتصال بالعالم الخارجي.

في هذا المشروع، يتم استخدام محرك أي سبيك (espeak) ( (Ramiz Kastrati et al لتحويل النصوص إلى كلام. (espeak) هو برنامج مفتوح المصدر ومضغوط لتحويل النصوص إلى كلام، ويستخدم طريقة “تكوين الأصوات” التي تساعده على دعم العديد من اللغات بحجم صغير. الصوت الناتج عن محرك espeak واضح ويمكن استخدامه بسرعات عالية.

مزايا محرك espeak:

– يتضمن أصواتًا متنوعة يمكن تعديل خصائصها.

– يمكنه إنتاج إخراج صوتي بصيغة WAV (موجة).

– يدعم SSML (لغة توصيف تحويل الكلام) (لكن بشكل غير كامل)، وأيضًا HTML.

– حجم البرنامج وبياناته صغير جدا (مضغوط)، بما في ذلك العديد من اللغات، يصل حجمه إلى بضع ميغابايتات.

– يمكنه ترجمة النصوص إلى أكواد الفونيمات، مما يجعله مناسبًا كواجهة أمامية لمحرك تحويل كلام آخر.

– إمكانيات لدعم لغات أخرى. هناك عدة لغات مدعومة بمراحل تطور مختلفة.

– مكتوب بلغة C.

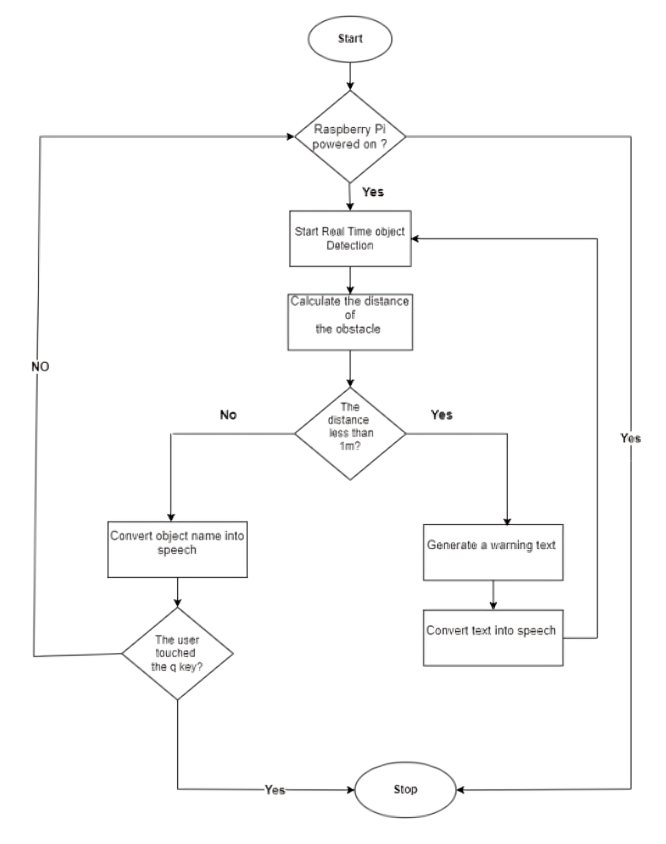

د. قياس العوائق والمسافات

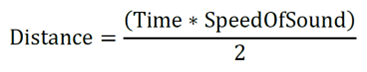

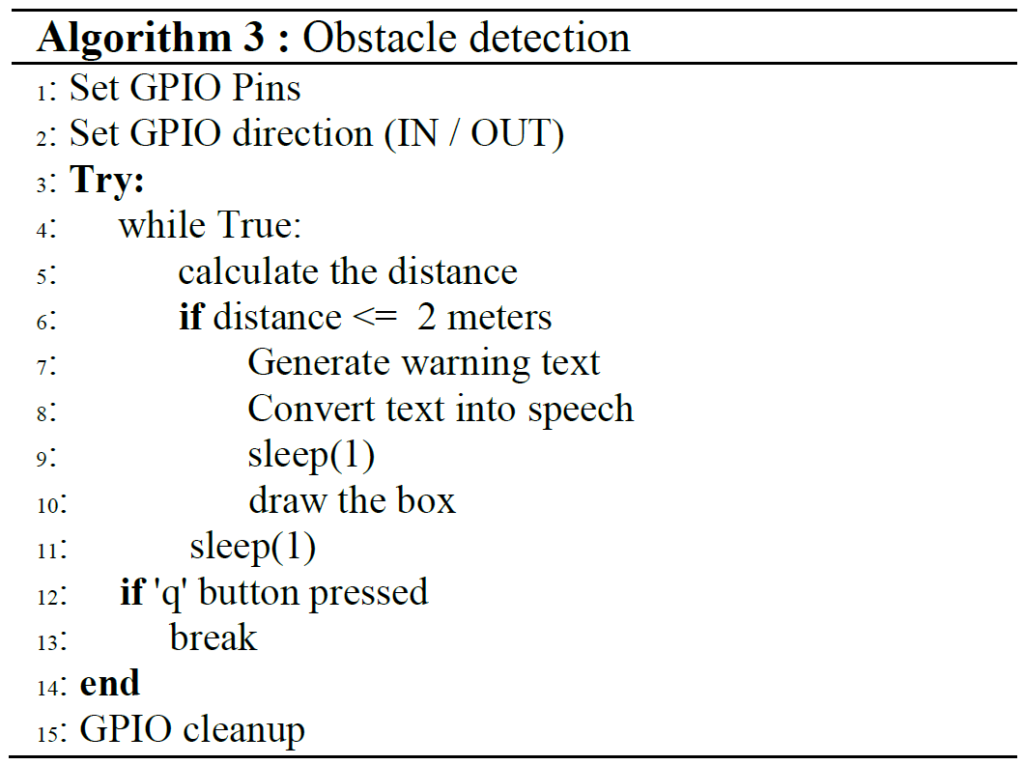

في هذه الدراسة، يتم استخدام مستشعر فوق صوتي لاكتشاف الكائنات في مكون تجنب العقبات. يتم حساب المسافة بين الجهاز والعائق، إذا كانت المسافة أقل من 2 متر، يقوم النظام بتوليد رسالة تحذيرية يتم تحويلها بعد ذلك إلى صوت.

يستخدم مستشعر الأشعة فوق الصوتية لقياس المسافة، حيث يبث أشعة فوق صوتي بتردد يقارب 40 كيلو هرتز. يحتوي المستشعر على قسمين رئيسيين: محول يولد الصوت فوق الصوتي وآخر يستمع لصدى الصوت. ينتقل الصوت بسرعة حوالي 340 متر في الثانية. لقياس المسافة، تُستخدم الصيغة التالية:

يتم قسمة النتيجة على 2 لأن الصوت يجب أن يتحرك ذهابًا وإيابًا.

الكود البرمجي التجريبي لاكتشاف العقبات كما يلي:

الرمز الزائف لاكتشاف العوائق موضح بالخوارزمية 3

6. النتائج والمناقشة

لتحديد أداء النظام المقترح، تم اختبار النظام تحت سيناريوهات متنوعة مثل تفاوت الإضاءة، والمسافة من الكاميرا، وعدد الكائنات في الإطار) وذلك لتحديد الكائنات في الوقت الفعلي، والتعرف على النصوص، وكشف العقبات، ثم تحويل جميع النتائج المستخلصة إلى كلام.

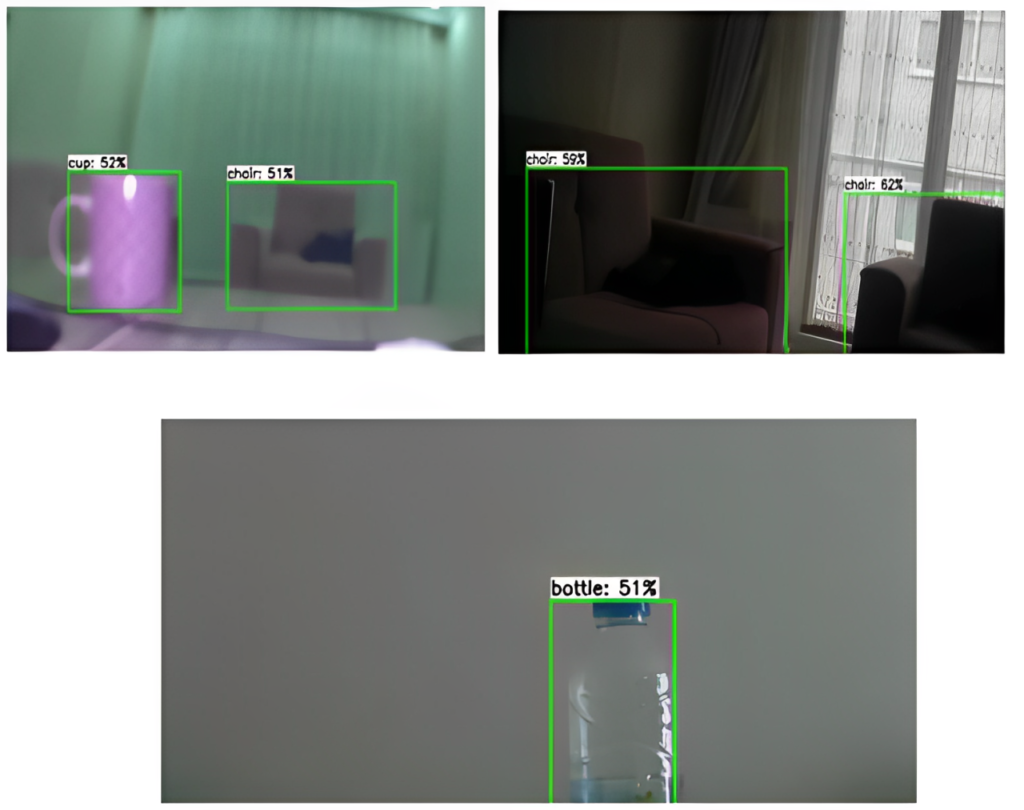

أ. كشف الكائنات في الإضاءة الطبيعية

تم اختبار النظام في غرفة بإضاءة طبيعية، النتائج موضحة في الشكل 17، وقد اكتشف النظام الكائن بدقة عالية. يمكن للنظام أيضًا اكتشاف أكثر من كائن واحد في نفس الإطار ووضع تسميات صحيحة على الكائنات.

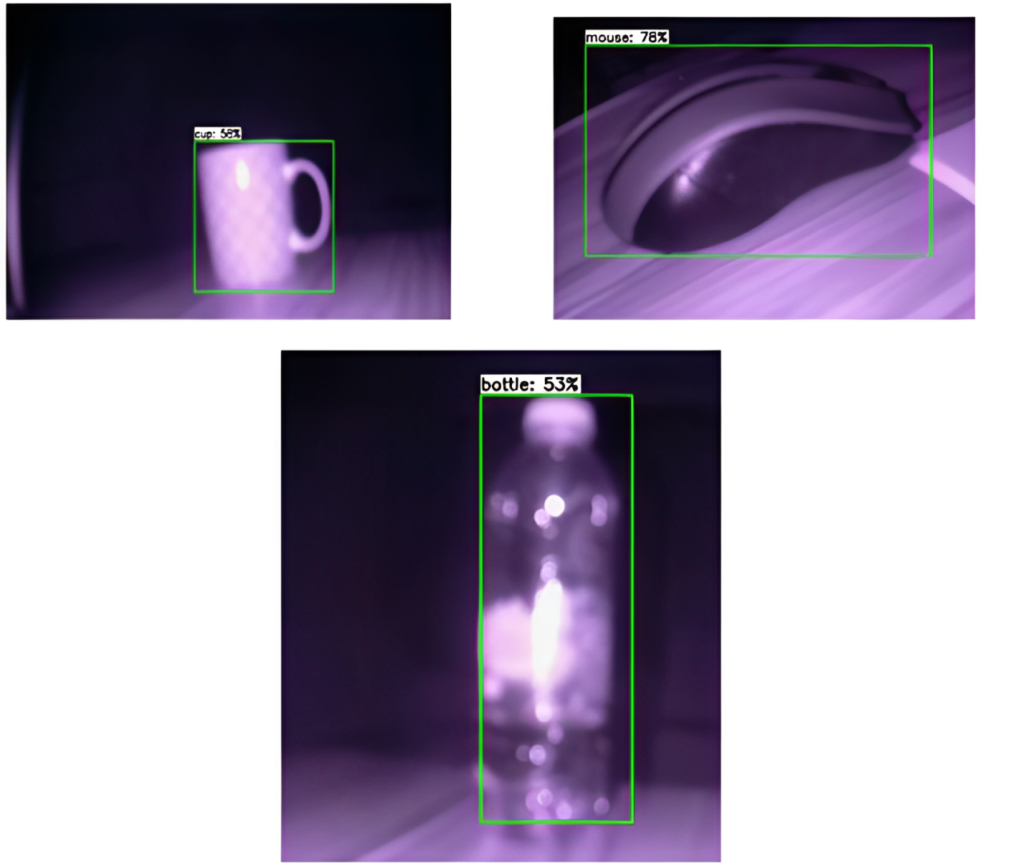

تم إجراء اختبار النظام في غرفة مظلمة، كما هو موضح في الشكل 18. تمكن النظام من اكتشاف الكائنات المختلفة بصحة مقبولة، حيث بلغت الصحة (ِAccuracy) 78% للفأرة و58% للكوب. تم استخدام كاميرا بالأشعة تحت الحمراء (IR) لإجراء الكشف في هذا الاختبار.

ب. كشف الكائنات في بيئة مظلمة أو ذات إضاءة منخفضة

تم إجراء اختبار النظام في غرفة مظلمة، كما هو موضح في الشكل 18. تمكن النظام من اكتشاف الكائنات المختلفة بصحة مقبولة، حيث بلغت الصحة (ِAccuracy) 78% للفأرة و58% للكوب. تم استخدام كاميرا بالأشعة تحت الحمراء (IR) لإجراء الكشف في هذا الاختبار.

كانت الكاميرا المستخدمة تعاني من مشكلة، حيث كانت بحاجة إلى تركيب عدسة مكبرة للتغلب على المشكلة. من بين المشاكل والقيود التي واجهت هذا الاختبار كانت الصور غير الواضحة أو غير المعروفة، كان ذلك بسبب لون الكائن وعلاقته بالألوان المحيطة به، والمسافة بين الكائن والكاميرا، وما إلى ذلك. يظهر الشكل 19 مثالًا نموذجيًا لكائن فشل الأداة في التعرف عليه. الكائن هو كرسي بذراعين بلون وردي وخلفية بيضاء.

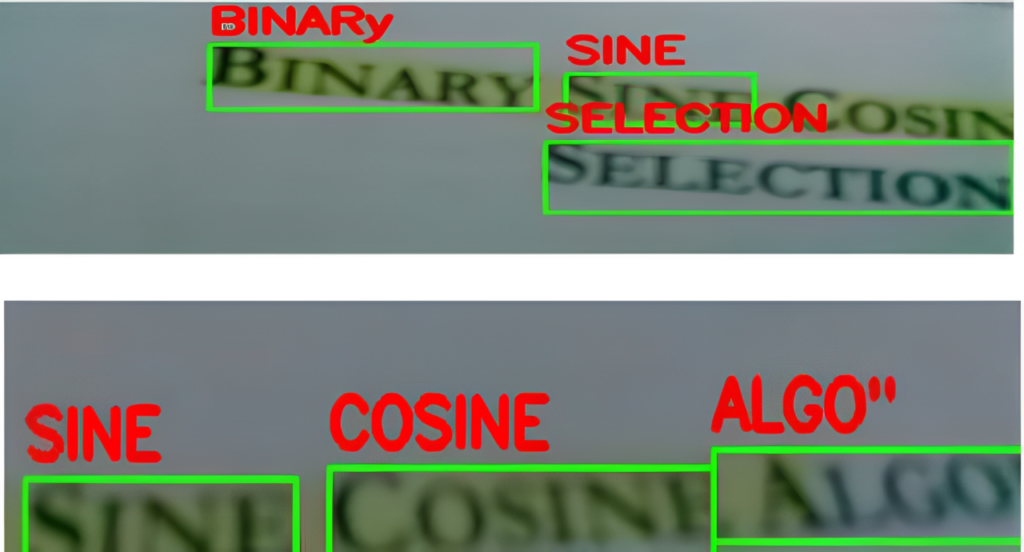

ج. التعرف على النصوص

تم اختبار النظام لقراءة ورقة علمية مطبوعة في الوقت الحقيقي، كما هو موضح في الشكل 20. تم التعرف على النصوص بشكل جيد، وفي الوقت نفسه، تم تحويلها إلى كلام باستخدام محرك espeak.

7. الاستنتاج

تم إنشاء أداة مساعدة لمساعدة الأشخاص ذوي الإعاقة البصرية على استكشاف العالم وأداء أنشطتهم اليومية بشكل أسهل. يوفر النظام الكشف عن الكائنات داخل الأماكن وخارجها، واكتشاف العقبات، والتعرف على النصوص في الوقت الحقيقي وتحويلها إلى صوت، وذلك لتزويد المستخدمين بالمعلومات التي تساعدهم في تجاوز مشاكل التنقل والكشف. كما توفر حلول للقدرة على قراءة الكتب.

تم اختبار النظام للتحقق من قدرته على تحقيق جميع المهام المقررة، وقد تم الحصول على نتائج جيدة بعد إخضاع الأجهزة لعدة اختبارات، بما في ذلك تحت الضوء النهاري الطبيعي، الضوء الساطع، والظلام الكامل في جزء الكشف عن الكائنات. كما تم اختبار قدرة تحويل النص إلى صوت في قراءة الصور والترجمات النصية في الفيديو.

الفهرس

- Ali Ali, Mohammad Abou Ali – Blind Navigation System for Visually Impaired Using Windowing-Based Mean on Microsoft Kinect Camera – (ICABME), 2017

- Bai, S. Lian, Z. Liu, K. Wang, and D. Liu, “Virtual-blind-road following based wearable navigation device for blind people,” IEEE, Feb. 2018.

- Barontini F, Bettelani GC, Leporini B, Averta G, Bianchi M. “A User-Centered Approach to Artificial Sensory Substitution for Blind People Assistance”,2020.

- Yi, R. W. Flores, R. Chincha, and Y. Tian, “Finding objects for assisting blind people,” Netw. Model. Anal. Heal. Informatics Bioinforma, 2013.

- Dakopoulos and N. G. Bourbakis, “Wearable obstacle avoidance electronic travel aids for blind: A survey,” IEEE, Jan. 2010

- Elizabeth D. Liddy, “Natural Language Processing”, Syracuse University, 2011

- Ahmed, S. Mahmud, R. Al-Fahad, S. Alam, and M. Yeasin, “Image Captioning for Ambient Awareness on a Sidewalk,” 2018

- Hasventhran Baskaran, Rachel Lum Mei Leng Fiza Abdul Rahim, Mohd Ezanee Rusli, “Smart Vision: Assistive Device for the Visually Impaired Community OnlineComputer Vision Service”, IEEE 2019.

- Hongxiang Fan , Shuanglong Liu, Martin Ferianc, Ho-Cheung Ng, Zhiqiang Que, Shen Liu, Xinyu Niu, Wayne Luk, “A Real-Time Object Detection Accelerator with Compressed SSDLite on FPGA”, International Conference on Field-Programmable Technology (FPT) , 2018

- Joe Louis Paul, S. Sasirekha, S. Mohanavalli, C. Jayashree, P. MoohanaPriya and K. Monika, “Smart Eye for Visually Impaired-An aid to help the blind people,”, India, 2019

- Patil, Q. Jawadwala, and F. C. Shu, “Design and construction of electronic aid for visually impaired people,” IEEE, Apr. 2018.

- Tepelea, I. Buciu, C. Grava, I. Gavrilut and A. Gacsádi, “A Vision Module for Visually Impaired People by Using Raspberry PI Platform,”,15th International Conference on Engineering of Modern Electric Systems (EMES), Oradea, Romania, 2019.

- Ehatisham-ul-Haq , Muhammad Awais Azam, Usman Naeem , Shafiq ur Rѐhman , Asra Khalid, Identifying Smartphone Users based on their Activity Patterns via Mobile Sensing, The 8th International Conference on Emerging Ubiquitous Systems and Pervasive Networks (EUSPN 2017)

- M. Islam, M. S. Sadi, K. Z. Zamli, and M. M. Ahmed, “Developing walking assistants for visually impaired people: A review,” IEEE, Apr. 2019

- Mark Sandler, Andrew Howard, Menglong Zhu, Andrey Zhmoginov, Liang-Chieh Chen “MobileNetV2: Inverted Residuals and Linear Bottlenecks”

- Mark Sandler, Andrew Howard, Menglong Zhu, Andrey Zhmoginov, Liang-Chieh Chen “MobileNetV2: Inverted Residuals and Linear Bottlenecks”

- Mauro Avila, Markus Funk, Niels Henze – DroneNavigator: Using Drones for Navigating Visually Impaired Persons – Conference Paper, October 2015

- Rama Murthy, N. Sudha,“Smart Navigation System For Visually Challenged People”, International Journal of Industrial Electronics and Electrical Engineering, Sep.-2016.

- Norharyati binti Harum, Nurul Azma Zakaria, Nurul Akmar Eimran, Zakiah Ayop, Syarulnaziah Anawar “Smart Book Reader for Visual Impairment Person using IoT Device”, 2019

- Sabin Prasanna, B. Bernadine Infenta, S. Maria Keerthana, Sherril Sophie Maria Vincent , “Book Reader using Raspberry Pi”, April 2018

- Velrajkumar, P.Ramesh, C.Senthilpari, T.Bhuvaneswari, V.Chitra, “Development Of Autonomous Robot For Tunnel Mapping Using Raspberry-Pi Processor”, MARCH 2020

- Parth Dhall, Pankaj Sharma, “A Review Paper On Assistive Shoe & Cane for Visually Impaired People”, International Journal of Scientific Research and Management Studies (IJSRMS), 2015.

- Radhika, P.G. Pai, S. Rakshitha and R. Srinath, “Implementation of Smart Stick for Obstacle Detection and Navigation.” International Journal of Latest Research in Engineering and Technology, 2016

- Rahmat Tullah, Syaipul Ramdhan , Reza Nabili Akbar , Fahmi Yusuf; “Smart-Cane for The Blind with A Sensor Detection Approach” Telematika, August (2020)

- Real, Santiago, and Alvaro Araujo. “Navigation systems for the blind and visually impaired: Past work, challenges, and open problems.”, (2019)

- REBEIRO SHARLENE SARA CARLTON, HUDA NOORDEAN, A Review on Object Recognition for Blind People Based on Deep Learning”, August 2018

- Roy Shilkrot, Jochen Huber, Wong Meng Ee, Pattie Maes, and Suranga Chandima Nanayakkara, “FingerReader: A Wearable Device to Explore Printed Text on the Go”, 2015

- Pehlivan, M. Unay and A. Akan, “Designing Obstacle Detection and Alerting System for Visually Impaired People on Side.

- SAMI UR RAHMAN, SANA ULLAH, SEHAT ULLAH, “Obstacle Detection in Indoor Environment for Visually Impaired Using Mobile Camera”, Journal of Physics: Conference Series 2018.

- Shankar Sivan, Gopu Darsan – Computer Vision based Assistive Technology For Blind and Visually Impaired People, Conference Paper · July 2016

- Shifa Shaikh, Vrushali Karale, Gaurav Tawde, Assistive Object Recognition System for Visually Impaired, International Journal of Engineering Research & Technology (IJERT), September-2020.

- SREERAJ M, JESTIN JOY, ALPHONSA KURIAKOSE, BHAMEESH M B, ANOOP K BABU, MERIN KUNJUMON, 2020 “VIZIYON: Assistive handled device for visually challenged”, December 2019.

URL-1 : Blindness and visual impairment, https://www.who.int/news-room/fact-sheets/detail/blindness-and-visual-impairment , (Access Date: 01 February 2022).

URL-2 : Inicio – Eyesynth | available on https://eyesynth.com, (Access Date: 01 February 2022).

URL-3 : eSight – Electronic eyewear for the visually impaired | available on https://esighteyewear.com , (Access Date: 01 February 2022).

URL-4 : NuEyes Pro | available on https://nueyes.com , (Access Date: 01 February 2022).

URL-5 : AngelEye Series – AngleEye Smart Reader and AngelEye Smart Glasses | available on https://closingthegap.com (Access Date: 01 February 2022).

URL-6 : OrCam MyEye 2.0 – For People Who Are Blind or Visually Impaired | available on https://orcam.com (Access Date: 01 February 2022).

URL-7 : OpenCV, https://opencv.org/about/ , (Access Date: 01 February 2022).

URL-8 : What is Speech Recognition? | Available on techtarget.com , (Access Date: 01 February 2022).

URL-9: CNN, ujjwalkarn.me/2016/08/11/intuitive-explanation-convnets/ , (Access Date: 01 January 2022)

URL-10: Depthwise Convolution ¸ https://paperswithcode.com/method/depthwise-convolution/ , (Access Date: 01 January 2022)

URL-11: COCO – Common Objects in Context (cocodataset.org) | https://cocodataset.org , (Access Date: 01 February 2022).

URL-12: TensorFlow Lite | available on https://www.tensorflow.org/lite/guide, (Access Date: 01 February 2022).